4

Zasoby cyfrowe

Motto:

W ciągu dziesiątków tysięcy lat na wszystkich kontynentach języki rozwijały się, zmieniały i ginęły bez śladu, ponieważ ginęły mówiące nimi ludy, brak zaś było metody utrwalania tych języków dla potomności

David Diringer, „Alfabet czyli klucz do dziejów ludzkości”, 1972, strona 24

Znak i kod

Pojęcie znaku użytkowane jest w wielu

naukach, często przybierając szeroką gamę odcieni znaczeniowych.

Badaniem systemów znaków zajmuje się semiologia (por. Guiraud [1974]).

Na potrzeby niniejszego opracowania znakami nazywane będą elementy

pewnego zbioru, służące do tworzenia komunikatów. W bardzo wielu

językach cyfry są podzbiorem podstawowego alfabetu. Semantyka

określonego znaku na ogół nie jest jednoznaczna, lecz ma charakter

konwencji. Na marmurowej płycie grobowca Machiavellego w kościele

Świętego Krzyża we Florencji czytamy co następuje:

NICHOLAVS.MACHIAVELLI

OBIT.AN.A.P.V. CIƆIƆXXVII.

Z kontekstu wynika, że ciąg symboli

CIƆ̑IƆXXVII, pojawiający się w ostatnim wierszu napisu na grobowcu,

jest zapisem daty śmierci, a użytym w nim znakom alfabetycznym

przypisano nowe znaczenie. Zakończony kropką ciąg siedmiu symboli

ostatniego wiersza CIƆ̑IƆXXVII jest całkowicie równoważny ciągowi

znaków MDXXVII. Odpowiednik ten podajemy ze względu na potencjalne

użycie syntezatora mowy przy interpretacji wersji online. W zapisie

oryginalnym zamiast litery M oznaczającej tysiąc (por. Ifrah [1990,

strona 142]), występuje ciąg trzech dużych liter, z których pierwsza

jest dużą literą C, a druga dużą literą I. Trzecia litera ma graficzną

formę odwróconej o sto osiemdziesiąt stopni litery C. Znak ten zwany

antisigmą został wprowadzony około 2 tysiące lat temu przez cesarza

Klaudiusza na oznaczenie głoski będącej zbitką ps [Diringer op.cit.

strona 516]. Kod tej litery do chwili obecnej nie jest implementowany

na syntezatorach i z tego względu cytowany napis został poddany

transkrypcji. W podobny sposób występująca w zapisie oryginalnym

sekwencja dwóch znaków: litery I oraz litery antisigma, została

zastąpiona równoważną jej pojedynczą literą D.

A więc te same znaki w jednym miejscu

oznaczały litery – w innym liczby. Rzym nie był tu żadnym wyjątkiem:

taką numeracją alfabetyczną posługują się jeszcze dzisiaj Żydzi przy

pisaniu dat według swego kalendarza oraz przy numerowaniu ustępów i

wersetów Starego Testamentu lub stronic dzieł wydanych po hebrajsku

(Ifrah [op.cit., strona 160]).

Zdawać by się mogło, że znaki mające tak dobrze ustaloną semantykę jak cyfry, występując poza obszarem tradycji nie powinny zmieniać swego znaczenia. Wszakże zostały przez człowieka wymyślone do spełniania ściśle określonej roli. Nie jest to jednak prawdziwe. Agresywność subkultury rynkowej, a zwłaszcza reklamy, w pogoni za wszelkimi formami mogącymi zaskoczyć odbiorcę i swą odmiennością zwrócić uwagę potencjalnego klienta zmieniła i tę sferę znaczeniową. Oto trzy przykłady z kręgu języków: polskiego (operator telefonii komórkowej Idea), angielskiego i francuskiego:

Tabela 3. Zmiana znaczenia liczb w tekście

reklamowym.

| Reklama | Tekstowa interpretacja reklamy | Fonetyczna alternatywa reklamy | Fonetyczna alternatywa reklamy |

| zdjęcie trzech kobiet rozmawiających przez telefony komórkowe pod którym jest słowo "kciuki" | trzy mamy kciuki | trzymamy kciuki | trzymamy kciuki |

| 4 sale | four sale | for sale | Na sprzedaż |

| O 20 sans O | O vingt sans O | Au vin sans eau | Przy winie bez wody |

Jak widać semantyka

znaków, z których buduje się liczby, już o dawna nie była ściśle

określona, a i obecnie styk świata cyfrowego z komercją pozostawia

różne drobne niejednoznaczności. Jednak w środowisku cyfrowym dobrym

obyczajem jest nie pozostawianie decyzji interpretacyjnych systemowi

lub aplikacji, lecz używanie różnego rodzaju podpowiedzi lub

formularzy, ułatwiających użytkownikowi podjęcie prawidłowej decyzji

interpretacyjnej.

Kodem nazwiemy wzajemnie jednoznaczne przyporządkowanie wszystkich

elementów pewnego skończonego zbioru odpowiednim elementom drugiego

skończonego zbioru. Jeżeli elementami jednego z tych zbiorów są liczby,

to kod nazywamy cyfrowym. W szczególności z różnych powodów kodowane

cyfrowo mogą być również cyfry/liczby. Tak np. w powszechnie stosowanym

w osobistych systemach komputerowych kodzie ASCII cyfrze 0

przyporządkowany jest kod dziesiętny 48, cyfrze 1 – kod 49 itd.

Przyczyny, dla których twórca kodu wybiera takie a nie inne

przyporządkowanie, są bardzo różne. W przypadku systemów

komunikacyjnych na ogół chodzi o skrócenie czasu przekazywania

komunikatów. W kodzie ASCII daleki od intuicji system kodowania cyfr

(jedynka nie ma kodu 1) wynika prawdopodobnie z najwyższego priorytetu

przypisanemu 32 kodom sterującym, dla których prosta struktura dekodera

gwarantowała najszybsze wykonanie stosownej instrukcji. Złożoność kodu

Morse’a dla danego znaku alfabetu jest odwrotnie proporcjonalna do

częstotliwości występowania kodowanego znaku w języku angielskim.

Najczęściej występująca w języku angielskim litera E jest kodowana

pojedynczą kropką. Takie „usprawnienie” wprowadzone na podstawie

czystej statystyki przez wynalazcę, w szczególnym przypadku może się

okazać spektakularnym niewypałem. Pierce [1967:63] podaje, że Ernest

Vincent Wright napisał w 1939 roku powieść, w której na 267 stronach

nie użył ani jednego wyrazu, w którym występowała by litera E. Mamy tu,

oczywiście, do czynienia z żartem literackim, nie zmienia to jednak

faktu, że kody dobre do jednych celów, mogą się okazać nieefektywne w

stosunku do innych celów [35].

Dla komputera

pamięć stanowi jednolitą masę bitów bez jakiejkolwiek widocznej

struktury. Prawdę tą przypomina nam Wirth [1989:17] i powinna ona

każdemu uświadomić, że interpretacja zawartości pamięci komputera

zależy od człowieka. Aby kiedykolwiek coś sensownego dało się wydobyć z

tej bezkształtnej masy, już na etapie pamiętania czegokolwiek komputer

musi wykonać coś, co doskonale jest znane każdemu biliotekarzowi:

skatalogować przechowywany zasób. I tu, podobnie jak i w wielu

bibliotekach, ekonomia obsady pamięci odgrywa dużą rolę. Dla nadania

pewnego porządku takiemu przedsięwzięciu we wszystkich językach

programowania definiuje się pewne typy danych, którymi wolno posługiwać

się programistom i użytkownikom. Z żalem trzeba powiedzieć, że ani

znaczenie (sens) poszczególnych typów danych, ani ich nazwy, nigdy nie

zostały ujednolicone. Najlepszym tego przykładem jest tabela,

porównująca typy danych obowiązujące w SQL, z typami danych

dopuszczalnymi w językach: Ada, C, Fortran, MUMPS, Pascal i PL/1

[Gruber, 1996, wewnętrzna strona tylnej okładki]. Bez specjalnego

ryzyka można przyjąć, że w znakomitej większości przypadków komputer

zaakceptuje następujące cztery typy danych prostych:

- liczby całkowite (typ integer)

- liczby rzeczywiste (typ real)

- wartości logiczne (typ Boolean)

- znaki dopuszczalne na urządzenia zewnętrznych, jak klawiatura i monitor (typ char)

Typy te wymieniane

są przez Iglewskiego et al. [1986] jako standardowe w Pascalu, nie

wymagające osobnej deklaracji. Wymienione cztery typy proste są typami

skalarnymi. Z typów prostych możemy tworzyć typy okrojone przez

zdefiniowanie odpowiednich podzbiorów. Na przykład miesiące mogą być

symbolizowane liczbami należącymi do podzbioru liczb naturalnych nie

większych od 12. Są jeszcze inne racje, dla których wypada wyróżnić

wymienione wyżej typy danych. W tym celu przyjrzyjmy się pewnemu

aspektowi sprzętowemu wydarzeń, które mają miejsce w komputerze.

Głównym elementem

procesora, wymienionego przez nas wcześniej wśród składników systemu

cyfrowego, jest jednostka arytmetyczno - logiczna, JAL (ang.

Arithmetic-Logic Unit, ALU). Jak nie trudno się domyślić, jednostka ta

może wykonywać zarówno operacje arytmetyczne (dodawanie i odejmowanie)

jak i logiczne (alternatywa, koniunkcja, negacja); a także przechowywać

końcowy wynik operacji. Bez większego ryzyka można również przyjąć, że

niemal każda współczesna JAL ma zintegrowaną obsługę liczb

rzeczywistych na poziomie koprocesora arytmetycznego (w rodzinie

procesorów firmy Intel fakt ten ma miejsce począwszy od modelu 486).

W tej sytuacji widzimy, że współczesny komputer ma od swego urodzenia

(jak to się w żargonie informatycznym określa: natywnie) wbudowane

wykonywanie operacji arytmetycznych na dwóch typach liczb: całkowitych

i rzeczywistych, oraz operacji logicznych na parach bitów (suma

logiczna, iloczyn logiczny), lub pojedynczych bitach (negacja). Bez

specjalnych skrupułów możemy więc powiedzieć, że typem prostym jest typ

bezpośrednio obsługiwany przez sprzęt systemu

[36].

Dla znaków definiuje się operację konkatenacji (sklejania znaków,

tworzenia łańcucha znaków). Operacja ta jest intuicyjnie oczywista,

wynika z potrzeby tworzenia napisów oraz sekwencyjnej pracy większości

urządzeń zewnętrznych.

Danymi pochodzącymi

z typów prostych można się posłużyć dla utworzenia różnego rodzaju

danych zagregowanych. Będziemy mówili, że agregaty te należą do typów

złożonych. Klasycznym - rzec by można - przedstawicielem tego gatunku

jest data kalendarzowa: trzy liczby, z których jedna określa rok, druga

miesiąc, trzecia - dzień. Niestety - i w tym przypadku panuje niezgoda

wśród ludzi. W skali świata nie udało się doprowadzić do ustalenia, w

jakiej kolejności te trzy liczby powinny być zapisywane. Tak na

przykład w USA obowiązującą kolejnością jest: Miesiąc/Dzień/Rok.

Natomiast w Polsce w powszechnym obiegu stosuje się dwa zapisy

zwierciadlane względem siebie: Dzień/Miesiąc/Rok oraz

Rok/Miesiąc/Dzień, - jeśli nie podjąć tematu różnic w używanych

separatorach, czy innej rachuby czasu w poza-chrześciańskich kulturach.

Istnienie tych niejednoznaczności może w pewnych przypadkach prowadzić

do nieporozumień, a nawet być przyczyną poważnych strat materialnych.

Data kalendarzowa jest archetypem wektora - skończonego,

uporządkowanego ciągu pewnych obiektów, mających w komputerze swoją

cyfrową reprezentację. Jako przykład wektora możemy podać symboliczny

opis zasobów w poszczególnych jednostkach pewnej biblioteki:

Tabela 4. Tabela jednowymiarowa jako przykład wektora . Opracowanie

autora.

| liczba

tytułów druków zwartych |

liczba

tytułów rękopisów |

liczba

roczników czasopism |

liczba

numizmatów |

liczba

wydawnictw kartograficznych |

Tabela 5. Tabela dwuwymiarowa. Przykład autora.

| Czytelnia ogólna |

2550 |

0 |

30 | 0 | 25 |

| Czytelnia czasopism | 120 | 0 |

175 |

0 |

|

| Zbiory specjalne |

4961 | 384 |

22 |

974 |

634 |

| Magazyn | 1332855 |

0 | 3879 |

0 |

226 |

Czytelnik zechce zauważyć, że dla wektorów obowiązują specjalne reguły,

opisujące wykonywanie operacji arytmetycznych. Po pierwsze dodawane

wektory muszą mieć identyczną liczbę składowych. Po drugie: suma dwóch

wektorów też jest wektorem o składowych, będących sumami odpowiednich

składowych dodawanych wektorów. Warto nadmienić, że niektóre procesory

mają wbudowane mechanizmy do sprzętowej realizacji operacji na

wektorach. Kilka wektorów ustawionych jeden pod drugim tworzy tablicę -

twór należący do kolejnego typu danych złożonych - typu tablicowego.

Albo może inaczej: wektor jest jednowymiarową tablicą. Tablice to

najpopularniejsze, złożone struktury danych, zbudowane z elementów tego

samego typu. Powyżej zapisana tablica była dwuwymiarowa. Nie nakłada

się żadnych formalnych ograniczeń na liczbę wymiarów tablicy.

Wszystkie elementy tablicy muszą być tego

samego typu. Jednak rzeczywistość nie składa się z zestawień wyłącznie

samych liczb, albo z samych tekstów. Było by to trudne do

zaakceptowania ograniczenie. Przeto wprowadza się swojego rodzaju

uogólnienie typu tablicowego i nazywa go typem rekordowym. Pojedynczy

rekord składa się z określonej liczby składowych zwanych polami, które

mogą być różnych typów. Tak oto definicyjnie przybliżyliśmy się do

obszaru, z którym wielu bibliotekarzy jest już nieco oswojonych.

W tym miejscu nie sposób przejść do

porządku dziennego nad sprawą nomenklatury. Termin rekord jest kalką

przeniesioną do nas z angielskiego. Podobnie jak w języku rosyjskim,

przekład tego terminu na polski nastręczał trudności. Przyczyn takiego

stanu rzeczy należy upatrywać w bogactwie możliwych technologicznych

kontekstów użycia tego słowa w języku angielskim. Wirth [1989]

przypomina pragmatyczne względy, dla których powołano to pojęcie i

wymienia cztery odcienie znaczeniowe tego terminu: zapis, rejestr,

nagranie, przechowywany zestaw informacji. Znakomitą analizę

semantyczną terminu electronic record

na gruncie języka angielskiego przeprowadził niedawno Morelli [1998].

Wnioski z tej analizy skłaniają do rezygnacji z używanego niekiedy w

Polsce terminu krotka i przyjęcia kalki rekord, jako pojęcia o dobrze

poznanej sferze znaczeniowej jej źródłosłowu.

Na końcu wymienimy niezmiernie ważny typ

plikowy. Pliki służą do wymiany informacji zarówno między dwoma

komputerami, jak i między komputerem a urządzeniem zewnętrznym. Na

wielkość plików nie nakłada się żadnych formalnych ograniczeń; oczekuje

się tylko, że plik bę dzie się składał z elementów tego samego typu.

Mamy więc pliki binarne, pliki tekstowe, pliki z zapisanym dźwiękiem,

pliki zawierające rekordy danych osobowych (np. kartoteki czytelników)

[37]. Każdy plik ma określonądługość i znacznik końca pliku (ang. End Of File, EOF). Z plikiem

należy kojarzyć operacje zapisu pliku oraz odczytu pliku. Trzeba

pamiętać, że pliki tworzone na jakimkolwiek nośniku zależą od systemu

operacyjnego, pod którym zostały wygenerowane. Fakt ten może stwarzać

pewne problemy przy przenoszeniu plików między odmiennymi systemami

operacyjnymi [38]. W dalszym ciągu, w

odniesieniu do technologii cyfrowej implementowanej w komputerach,

będziemy utożsamiać pojęcie pliku z pojęciem zbioru.

Bazy danych to termin, który jest

zakorzeniony w technologii komputerowej od bardzo dawna i głęboko już

wrósł w realia dzisiejszego dnia. Baza danych to zbiór wystąpień

różnych rekordów oraz opisów powiązań między rekordami, danymi

zagregowanymi i danymi elementarnymi [Martin, 1983:26]. Zagadnienie

projektowania, testowania i eksploatacji baz danych jest bardzo

złożone. Na łamach niejszej książki nie ma najmniejszych szans nawet na

fragmentaryczne naszkicowanie terminologii i z tych względów

poprzestaniemy na odesłaniu zainteresowanego czytelnika do

specjalistycznej literatury [Date 1981, Martin 1983, Gruber 1996]. Do

zagadnienia tego jednak odwołamy się w dalszym ciągu jeszcze raz,

omawiając dostęp do zasobów cyfrowych, aby nakreślić raczej mało znaną

bibliotekarzom problematykę logiki trójwartościowej.

Plik cyfrowy

identyfikuje się przez nazwę. W pierwszych wersjach systemu DOS na

nazwę nakładano dodatkowe ograniczenia. Nie mogła być ona dłuższa od 8

liter z repertuaru ASCII, cyfr oraz znaków interpunkcyjnych, plus co

najwyżej trzy-literowe rozszerzenie podawane po kropce. Restrykcje

nakładane na nazwę pliku zakazywały również używania 14 wyróżnionych

znaków:

. „ \ / [ ] : < > + = ; ,

W obecnych systemach te ograniczenia zostały znacznie zliberalizowane.

Warto jednak dodać, że swojego rodzaju ukłonem osób projektujących

złożone dokumenty internetowe jest nadawanie nazw w miarę możliwości

zgodnych ze starymi ograniczeniami DOSu. Pewnych kłopotów dostarcza

niekiedy transgraniczna wymiana plików. Pliki wykorzystujące w nazwach

kody przekraczające 128 (np. nazwy pisane cyrylicą) po zmianie

środowiska systemowego na ogół wymagają zmiany nazwy.

Jeżeli w systemie występuje struktura katalogów, to odwołanie się do

pliku na ogół zawsze wymaga podania pełnej specyfikacji pliku (to

znaczy nazwy poprzedzonej tzw. ścieżką dostępu do pliku). Przyzwyczaić

się tu trzeba do różnic pomiędzy Unixem a DOS i Windows. W tym

pierwszym przejście na inny poziom katalogu oznacza się znakiem /

podczas, gdy w dwóch pozostałych znakiem \ .

W miarę rozwoju technologii cyfrowej wytwórcy oprogramowania utrwalili

w użytkownikach obyczaj rozpoznawania typu pliku po rozszerzeniu jego

nazwy.

Tabela 6. Wybrane typy plików. Wybór autora.

| Rozszerzenie |

Typ

pliku |

| com |

plik wykonywalny |

| exe |

plik wykonywalny |

| bat |

plik wsadowy

(zbiór komend systemowych do automtycznego wykonania) |

| sys |

plik systemowy

(zawierający informację o żądanej konfiguracji systemu) |

| tmp |

plik pomocniczy |

| txt | plik tekstowy

(w domyśle zawierający tylko znaki ASCII) |

| doc |

plik tekstowy

formatowany (w zasadzie utożsamia się z plikiem zredagowanym pod którąś

z mutacji edytora MS Word) |

| wp |

plik tekstowy

formatowany, zredagowany pod edytorem Word Perfect |

| rtf |

plik tekstowy

formatowany zredagowany w formacie Rich Text Format |

| htm, html | plik

hipertekstowy zredagowany w formacie HTML |

| ps | plik w formacie

PostScript |

| wav |

plik dźwiękowy |

| au |

plik dźwiękowy |

| jpg, jpeg |

plik graficzny

w formacie JPEG |

| tif, tiff |

plik graficzny

w formacie TIFF |

Niesłychanie bogaty

alfabetyczny indeks stosowanych typów plików można znaleźć na sieci pod

URL:

http://whatis.techtarget.com/fileFormatA/0,289933,sid9,00.html.

Cyfrowy plik tekstowy podparty technologią uwierzytelnionego podpisu elektronicznego to kamień węgielny współczesnej gospodarki elektronicznej. Na mocy współczesnego ustawodawstwa autor tekstu cyfrowego nadaje swemu cyfrowemu podpisowi taką samą moc prawną, jak podpisowi odręcznemu, a przesłanemu tekstowi pełne cechy dokumentu de iure.

Podstawowym

rodzajem tekstu jest tekst niesformatowany. Tekst niesformatowany to

typowy tekst używany w tradycyjnej, unixowej poczcie elektronicznej.

Nie zawiera on żadnych wskazówek, mogących wpływać na stronę

prezentacyjną. To tekst monochromatyczny, mający ten sam typ, rodzaj i

wielkość czcionki. Zwykle też nie wykracza poza alfabet angielski

[39] choć oczywiście istniejeoprogramowanie, pozwalające na poziomie konsoli unixowej operować

pełnym zestawem czcionek narodowych całego świata.

Już w pierwszych zaawansowanych komputerach osobistych, pracujących pod nadzorem systemu CP/M istniała możliwość przypisania każdemu znakowi widocznemu na ekranie komputera ograniczonej liczby wyróżników (atrybutów): podkreślenia wyświetlanego znaku i wygaszenia jego jasności o połowę. Polegało to na tym, że pamięć ekranu zamiast 8-bitowego modułu, służącego do pomieszczenia wyświetlanego znaku miała moduł 9-bitowy. Ponieważ do wyświetlenia podstawowego zestawu znaków ASCII wystarczy 7 bitów, więc ósmy, standardowy bit był używany jako wskaźnik podkreślenia znaku, a dziewiąty, dodatkowy - jako wskaźnik kontroli jego jasności.

Włączanie i

wyłączanie pewnych atrybutów tekstu jest uzasadnione praktyką

poligraficzną i zostało unormowane przez ANSI w postaci tzw. sekwencji

escape. Pod nazwą tą kryje się sekwencja znaków sterujących ruchami

kursora, definiowaniem klawiatury oraz modyfikacją wyświetlacza

graficznego. Aktywizację mechanizmu tych sekwencji użytkownik mógł

wcześniej poznać w systemie DOS w związku z konfiguracją pliku

config.sys

[40]. Sekwencja escape zaczynasię niewidocznym na ekranie znakiem, generownym przez naciśnięcie

klawisza ESC (kod dziesiętny 27), po którym następuje ciąg parametrów.

Wymienimy kilka sekwencji escape ograniczonych wyłącznie do kontroli

monitora:

Tabela 7. Sekwencje escape. Wybór autora.

| Atrybut

tekstu |

Sekwencja |

| Wyłączenie wszystkich atrybutów | ESC [ 0 |

| Wytłuszczanie (włączenie) |

ESC [ 1 |

| Podkreślanie (włączenie) | ESC [ 4 |

| Migotanie (włączenie) | ESC [ 5 |

| Inwersja video (włączenie) | ESC

[ 7 |

| Ukrycie tekstu (wyłączenie) | ESC

[ 8 |

W podobny sposób

można sterować kolorem tekstu i jego tła - w tabeli jest to drugi,

liczbowy parametr sekwencji escape, który w przypadku sterowania barwą

zmienia się w granicach od 30 do 47 (te sekwencje są już zgodne z normą

ISO 6429).

A więc dla tekstu można zdefiniować rodzaj fontu i jego wielkość, można

tekst lokalnie ukryć, ujawnić ukryty, spowodować jego migotanie,

podkreślić, pochylić (posłużyć się kursywą), zmienić jego barwę, - ale

można też określić język tekstu (ważne przy edytorach wyposażonych w

słowniki ortograficzne, oraz przy wielojęzycznych syntezatorach mowy).

Zamierzona kompozycja zespołu wyróżników (atrybutów) tekstu będzie

przez nas nazywana stylem tekstu.

Formatowanie tekstu

to nadanie mu żądanej formy, kształtu prezentacyjnego. Elementy, które

należy tu wyróżnić, to:

Skład tekstu ma na

celu końcowe przygotowanie tekstu do publikacji. Skład tekstu to

nałożenie stylów i formatowania na strukturę fizycznych wymagań

środowiska prezentacyjnego (drukarka, naświetlarka, ploter, ekran,

syntezator mowy). Produkt będący wynikiem składu musi być bezpośrednio

rozumiany przez urządzenie techniczne, realizujące finalną postać

publikacji.

Wybrany tekst

niejednokrotnie dobrze jest przedstawić w formie alternatywnej. Taki

zabieg służy wówczas konkretnemu celowi. Sens alternatywnego zapisu

jest natychmiast rozumiany, gdy chodzi np. o wydawnictwo drukowane

brajlem. Jednak tym razem zreferowana będzie alternatywna forma zapisu

ułatwiająca szybkie wprowadzanie zapisu do systemu cyfrowego. Mowa tu

będzie o bardzo już popularnej formie zapisu, zwanej kodem paskowym

(ang. bar code). Ten bardzo pożyteczny kod został zaprojektowany na

potrzeby handlu celem szybkiego przetwarzania informacji o towarze.

Obecnie rozpowszechnił się on na wiele innych dziedzin, znamy go dobrze

ze sklepów i chyba na dobre zadomowił się już w wielu bibliotekach.

Obecnie kod paskowy występuje w dwóch głównych odmianach:

jednowymiarowej i dwuwymiarowej. W tym ostatnim przypadku występują

zresztą zarówno wersje kropkowe (plamkowe), jak i paskowe.

Najpierw zreferowany będzie przypadek jednowymiarowy. Na początek małe

wyjaśnienie. Nawet w przypadku jednowymiarowym nie osiągnęliśmy takiego

poziomu standaryzacji, by na świecie użytkowany był tylko jeden,

jednowymiarowy kod paskowy. Już w tej chwili liczba ich jest znaczna.

Dużo pożytecznej informacji na ten temat można znaleźć na sieci:

http://www.adams1.com/pub/russadam/stack.html

http://www.spatula.net/proc/barcode/code39.src

Oto nazwy kilku

popularnych specyfikacji: kod 2 z 5 (ang. Code 2 of 5), kod 2 z 5 z

przeplotem (ang. Code 2 of 5 Interleaved), kod 3 z 9, kod 128 UCC/EAN

128, kod EAN 8/13

[42] , PostNet, UPC-A, UPC-E.Na przykładzie kodu "3 z 9" (trzy z dziewięciu) spróbujemy

przeanalizować jego budowę. Na wstępie przedstawimy tytuł niniejszego

paragrafu w symbolice zwykłego kodu ASCII oraz kodzie "3 z 9".

Tabela 8. Reprezentacja tekstu w symbolice ASCII oraz symbolice kodu "3

z 9" (opracowanie własne).

| Font Lucida Sans Unicode 12 pts | Font 3 of 9 Barcode 36 pts |

| Alternatywna | Alterna tywna |

| wizualizacja | wizualizacja |

| tekstu | tekstu |

Na kod ten składa

się sekwencja 5 czarnych pasków (p), między którymi są 4 białe odstępy

(o). Zarówno paski, jak i odstępy mogą występować w wersji szerokiej,

jak i wąskiej. W tej sekwencji szerokie muszą być trzy spośród

dziewięciu elementów (stąd nazwa kodu). Stosunek szerokości większego

elementu kodu (paska lub odstępu) do mniejszego nie jest standaryzowany

i powinien zawierać się w przedziale 2,25:1 do 3:1. Schemat ten daje

możliwość zakodowania 43 znaków, w tym cyfr, dużych liter alfabetu

angielskiego oraz znaków używanych w księgowości (+ - * / % . symbol

waluty - np. $ ). Do celów obsługi księgowej każdy pełen kod paskowy

powinien być poprzedzony znakiem początku kodu i zakończony znakiem

końca kodu. Dla kodu "3 z 9" rolę obydwu ograniczników odgrywa ten sam

znak kontrolny: jest to znak mnożenia (*). Poszczególne znaki tekstu

separowane są pojedynczym wąskim odstępem. Słowa zapisane w powyższym

przykładzie nie zawierają dopisanych ograniczników kodu. Przyjrzyjmy

się bliżej definicji tego kodu. W poniższej tabelce zestawiony jest

fragment kodu

Tabela 9. Fragment

specyfikacji kodu kreskowego 3 z 9 w postaci źródłowej i prezentacyjnej.

W - element wąski, S - element szeroki (opracowanie własne)

| Znak |

Wartość |

p1 |

o1 |

p2 |

o2 |

p3 |

o3 |

p4 |

o4 |

p5 |

Postać prezentacyjna znaku |

| 0 |

0 |

W |

W |

W |

S |

S |

W |

S |

W |

W |

0 |

| 1 |

1 |

S |

W |

W |

S |

W |

W |

W |

W |

S |

1 |

| 2 |

2 |

W |

W |

S |

S |

W |

W |

W |

W |

W |

2 |

| 3 |

3 |

S |

W |

S |

S |

W |

W |

W |

W |

W |

3 |

| 4 |

4 |

W |

W |

W |

S |

S |

W |

W |

W |

S |

4 |

| 5 |

5 |

S |

W |

W |

S |

S |

W |

W |

W |

W |

5 |

| 6 |

6 |

W |

W |

S |

S |

S |

W |

W |

W |

W |

6 |

| 7 |

7 |

W |

W |

W |

S |

W |

W |

S |

W |

S |

7 |

| 8 |

8 |

S |

W |

W |

S |

W |

W |

S |

W |

W |

8 |

| 9 |

9 |

W |

W |

S |

S |

W |

W |

S |

W |

W |

9 |

| A |

A |

S |

W |

W |

W |

W |

S |

W |

W |

S |

A |

| B |

B |

W |

W |

S |

W |

W |

S |

W |

W |

S |

B |

| C |

C |

S |

W |

S |

W |

W |

S |

W |

W |

W |

C |

| D |

D |

W |

W |

W |

W |

S |

S |

W |

W |

S |

D |

| E |

E |

S |

W |

W |

W |

S |

S |

W |

W |

W |

E |

| F |

F |

W |

W |

S |

W |

S |

S |

W |

W |

W |

F |

| G |

G |

W |

W |

W |

W |

W |

S |

S |

W |

S |

G |

| H |

H |

S |

W |

W |

W |

W |

S |

S |

W |

W |

H |

| odstęp |

W |

S |

S |

W |

W |

W |

S |

W |

W |

|

Kod paskowy może służyć do zapisywania

zarówno liter jak i cyfr. Pokazaliśmy powyżej, że tytuł niniejszego

paragrafu potrafimy zapisać kodem paskowym na papierze. Zrobiliśmy to

przy pomocy komputera i drukarki, ale całkiem nieźle mogło by nam się

to udać przy pomocy dwóch precyzyjnych rapidografów różnej szerokości,

albo odpowiednio przygotowanych na frezarce matryc celuloidowych oraz

czarnej farby w aerozolu. I w takich wersjach ten zapis cyfrowy

naprawdę nie miał by nic wspólnego z komputerem, czy elektroniką. Do

odczytania tego kodu potrzebna jest tylko kompletna tabelka jego

definicji. Jak nie trudno sobie wyobrazić, odkodować go można przez

wizualne porównanie zapisu z tabelą kodu, choć z pewnością jest to

żmudne i powolne. Podobnie zapis cyfrowy, na przykład "czysty" zapis

binarny możemy zrealizować praktycznie na dowolnym nośniku, bez związku

z jakąkolwiek elektroniką. Można wykuć w granicie ciąg zer i jedynek,

albo kropek i kresek, umownie przedstawiających poszczególne bity. I to

będzie znakomity, bardzo trwały zapis cyfrowy. Dla posiadacza takiego

zapisu realnym problemem będzie tylko to, jak sprawnie odczytywać i

przetwarzać zapisaną informację. I tu elektronika pokazuje swoje

prawdziwe zalety. Tym nie mniej konkluzja jest klarowna: zapis cyfrowy

może być zrealizowany w różnych technologiach. Jedną z nich, ale nie

jedyną i nie wyłączną, jest technologia elektroniczna. Są jednak

również inne technologie zapisu cyfrowego, a przykładem takiego zapisu

jest kod paskowy. Nie inaczej było z technologiami perforacji kart i

taśm papierowych używanych jeszcze w latach 80-tych do wprowadzania

cyfrowych danych do komputerów i sterowania obrabiarek numerycznych, a

również amerykańskich kart do głosowania w czasie wyborów prezydenckich

w roku 2000.

Jednowymiarowy kod paskowy ma jednak swoje

ograniczenia. Do podstawowych ograniczeń należy repertuar

dopuszczalnych symboli, które podlegają kodowaniu. Dokuczliwość tego

ograniczenia udało się znacznie zmniejszyć przez wprowadzenie kodowania

dwuwymiarowego. Nie ma tu nic zaskakującego, że tym sposobem kodowania

bardzo interesują się kraje dalekowschodnie. Jako przykład takiego kodu

podamy kod QR (od ang. Quick Response Code), opracowany przez

Nippondenso ID Systems i udostępniany w klasie licencji publicznych

(ang. Public Domain). Kod ten jest tworzony w postaci kompozycji trzech

narożnych symboli, określających przestrzenną orientację kodu, oraz

pola danych. Kompozycja ta wypełnia kwadrat małymi komórkami, również o

kształcie kwadratu. Maksymalny rozmiar matrycy kodu QR to 177

modularnych kwadratów zdolnych zakodować 7366 znaków numerycznych lub

4464 znaków alfanumerycznych. Ważną cechą tego kodu jest możliwość

bezpośredniego kodowania znaków znajdujących się w japońskich

sylabariuszach (kanji, kana). Osobom niewidzącym polecamy

wyłącznie identyfikację symboli przestrzennej orientacji kodu. W

analizowanym tu przykładzie są to trzy kwadraty o rozmiarze 7 na

7 komórek. Każdy symbol składa się z jednokomórkowej, ciemnej (w naszym

przykładzie granatowej) "skórki", jednokomórkowego, jasnego "miąższu"

oraz ciemnej "pestki" o rozmiarze 3 na 3 komórki. Dla ułatwienia

identyfikacji do ciemnych komórek wpisana została mała litera "c",

natomiast komórki wypełnione jasnym tłem są puste. Wszystkie trzy

symbole przestrzennej

orientacji kodu oddzielone są

jednokomórkowym, jasnym pasem od pola danych. Rozkład zaciemnionych

komórek w polu danych generowany jest algorytmicznie i dla postronnego

obserwatora jawi się jako czysto losowy, nie niosący żadnej informacji.

Rysunek 21. Dwuwymiarowy kod towarowy QR. Opracowanie własne na podstawie materiałów użyczonych autorowi przez Nippon Denso

|

Kod ten, podobnie jak i kilka innych kodów, ma możliwość korekcji błędów wywołanych uszkodzeniem zapisu lub defektem urządzenia odczytującego. Dzięki posiadanej nadmiarowości, oryginalnie zapisana przy pomocy tego kodu informacja może być poprawnie odtworzona przy częściowym zniszczeniu, uszkodzeniu lub zabrudzeniu zapisu. Jak widać z przytoczonego przykładu, rozmiar powierzchni kwadratu zajmowanego przez kod dwuwymiarowy zwiększa się w miarę wzrostu liczby kodowanych bajtów (pojedynczy znak kanji kodowany jest na 3 bajtach)

Hipertekst to uogólnienie klasycznego

tekstu w środowisku cyfrowym. Elementami odróżniającymi hipertekst od

tekstu są:

- możliwość rozszerzenia ilustracji tekstu mediami strumieniowymi (dźwięk, ruchomy obraz)

- możliwość dynamicznego wkomponowania odsyłaczy do obcych dokumentów hipertekstowych dostępnych na Sieci

- możliwość wbudowania "gorących łączników", umożliwiających szybkie przemieszczanie się w ramach danego dokumentu i inicjację usług sieciowych (redakcję formularza poczty elektronicznej, otwarcie sesji ftp czy telnet)

Dokumenty hipertekstowe przygotowuje się

obecnie w kilku różnych standardach, wywodzących się ze wspólnego

rdzenia: normy ISO 8879 definiującej Standard Generalized Markup

Language (SGML). Największą popularność na świecie zdobył sobie jego

dialekt o nazwie HTML (Hyper Text Markup Language), najnowszą odmianą

jest XML (Extensible Markup Language). Przykładami przeniesień

koncepcji SGML na inne obszary zastosowań może być język opisu

rzeczywistości wirtualnej VRML, lub języki opisu mówionego tekstu SSML

[Taylor 1997] i STML [Sproat 1997]. W dalszym ciągu nie podejmiemy

dawno zapoczątkowanej dyskusji na temat wad i ograniczeń tak

niewiarygodnie dziś popularnego dialektu SGML jakim jest HTML. Ma on w

istocie sporo wad, z których niektóre są postrzegane jako zalety. Tak

na przykład liberalność przeglądarek hipertekstowych, interpretujących

wyłącznie poprawne składniowo fragmenty publikacji, a ignorujące

fragmenty niezgodne z implementowaną składnią, jest uważana za zaletę.

Taka implementacja interpretuje co prawda publikacje zawierające błędne

konstrukcje składniowe (te są w zasadzie ignorowane przez

przeglądarki), ale zarazem interpretuje znaczne, "klasyczne" fragmenty

publikacji przygotowanych w nowszych mutacjach formatu HTML, jeszcze

przez przeglądarkę nie zaimplementowanych. Daje to szanse szybkiego

rozwoju formatu z niewielkim uszczerbkiem dla jakości publikacji.

Liczba publikacji stosująca format HTML przekracza o rzędy wielkości

liczbę publikacji w pozostałych formatach i trzeba być wyjątkowo

naiwnym, by wierzyć w realność migracji tych publikacji do formatu XML

w skali globalnej. Na to jest już za późno. Można tu się chyba zgodzić,

że zwykle wygrywa narzędzie proste, bardziej prymitywne, za to masowo

stosowane.

Formatowanie hipertekstu polega na wpisaniu

explicite stylów i dyrektyw formatujących w zwykły tekst. Jest to

ogromna zaleta, zważywszy, że komercyjne produkty na ogół oferują tekst

zakodowany, zazdrośnie chroniąc swych warsztatowych tajemnic. Taki

"otwarty" plik tekstowy jest niesłychanie bezpieczny dla właściciela -

edytować go można niemal "byle czym". Nie zamierzamy przeprowadzać tu

kursu formatowania tekstu w standardzie HTML - można to znaleźć w

licznych, dostępnych od kilku lat na rynku księgarskim książkach

[Macewicz 1996, Taylor 1996]. Czytelnikowi wrogo nastawionemu do

przyswajania sobie nowych pojęć, ale posiadającego umiejętność

posługiwania się edytorami MS Word (ten rekomendujemy począwszy od

wersji Word 97) lub Corel Word Perfect (rekomendujemy od wersji 8)

zalecamy przygotowanie sobie wersji "zwykłego" dokumentu, a następnie

wyeksportowanie go do formatu HTML. Czytelnik łatwo się przekona, że

tolerancja przeglądarek w stosunku do odstępstw od zalecanej składni

publikacji jest wręcz niewiarygodna.

Znaczniki używane do nadawania tekstowi

jego atrybutów i formatowania go są zestawiane w postaci pary: atrybut

otwiera się znacznikiem <nazwa atrybutu> i kończy się znacznikiem

</nazwa atrybutu>. Nazwy standardowo pochodzą z języka

angielskiego i każda osoba, operująca podstawowym słownictwem

edytorskim w tym języku szybko chwyta zasady formatowania hipertekstu

według definicji HTML. Nie przewiduje się wprowadzenia narodowych

wersji języka znaczników. Wymienimy dla przykładu kilka najprostszych

znaczników:

Tabela 10. Wybrane znaczniki formatowania HTML.

| Atrybut

|

Znacznik

początku |

Znacznik

zakończenia |

| Wytłuszczenie

tekstu |

<B> |

</ B > |

| Kursywa |

<I> |

</I> |

| Wielkość i kolor fontu |

<FONT SIZE=6

COLOR="#0000FF"> |

</ FONT > |

| Centrowanie

tekstu |

<CENTER> | </CENTER> |

Wymienione znaczniki tekstu (ewentualnie tła tekstu) odnosiły się do

tej pory tylko do obsługi użytkownika czytającego (oglądającego) tekst.

Jednak z różnych powodów użytkownik może nie być w stanie w ogóle

widzieć tekstu (jest niewidomy, lub ma chore oczy), bądź nie chcieć go

chwilowo widzieć (jest zajęty innymi sprawami). Równocześnie ten sam

użytkownik ma możliwość przesłuchiwania wyselekcjonowanego tekstu przy

pomocy syntezatora mowy. Okazuje się, że rozwój współczesnych

syntezatorów mowy wyprzedził technologię języków opisu publikacji

hipertekstowych. Mówiąc inaczej, twórcy tych języków mało wiedzieli o

potrzebie zastosowania syntezatorów mowy do przeglądania publikacji

internetowych. Na rzecz zdefiniowania takiego standardu zawiązało się w

ostatnich latach pod nazwą SABLE konsorcjum sześciu instytucji (

http://www.cstr.ed.ac.uk/projects/sable/).Spośród nowych znaczników proponowanych przez SABLE wymienimy:

czteropoziomową emfazę, czteropoziomową przerwę w czytaniu,

pięciopoziomową szybkość czytania, czteropoziomową głośność, płeć

lektora i pięć kategorii wieku lektora. Czytelnik zechce tu docenić

zalety tolerancji przeglądarek. Każdą publikację hipertekstową można

wzbogacić o znaczniki sterujące syntezatorem, praktycznie bez żadnego

wpływu na jej interpretację.

Niezwykle nowatorskie podejście do

formatowania tekstu, zorientowanego na systemy syntezatorów mowy,

zaprezentował Raman [1998]. W oparciu o zdefiniowane przez siebie

rozszerzenie języka Common Lisp skonstruował on formater audio o nazwie

AFL (ang. Audio Formatting Language), który w środowisku przeglądarki

opartej o syntezator mowy może być uważany za odpowiednik Postscriptu.

Autor tego rozwiązania (sam zresztą całkowicie niewidomy) doprowadził

niemal do perfekcji stworzony przez siebie zespół narzędzi

programistycznych o nazwie Audio System for Technical Readings (ASTER)

[44], umożliwiającychniewidomym tworzenie i analizę złożonych tekstów matematycznych z

pomocą syntezatora mowy. Lektura znakomitej książki Ramana, osobiście

złamanej do druku przez samego jej autora, pozostawia na każdym jej

czytelniku niezatarte wrażenie i ze wszech miar jest godna polecenia.

Przyjrzyjmy się, jak ASTER przekłada na angielską mowę wzór Faa de

Bruno, zaczerpnięty przez Ramana z pierwszego tomu znakomitej książki

Knutha [1968] - patrz ćwiczenia do paragrafu 1.2.5, zadanie 21:

Równanie 1. Wzór Faa de Bruno.

| Dnx w |

= | ∑ |

∑ |

Dju

w |

n! (D1x

u)k1...(Dnx u)k

n

k1! (1!)k1.....kn! (n!)k n |

| 0≤ j ≤ n |

k1+k2+...+kn

= j |

||||

| k1+2*k2+...+n*kn

= n |

|||||

| k1,k2,...,kn≥0 |

Wzór powyższy odczytywany jest następująco

[45] (plik dźwiękowysec18-ex3.au dostępny jest pod adresem

http://www.cs.cornell.edu/home/raman/aster/demo.html):

Ennth

derivative with respect to x of w equals summation over

0 less than or equal to j less than or equal to n

The quantity being summed summation over

k1 plus k2 plus AND SO ON plus kn equals j and below that

k1 plus 2k2 plus AND SO ON plus nkn equals n and below that

k1 comma k2 comma ellipsis comma kn greater than or equals to 0

The quantity being summed

jayth derivative with respect to u of w

[46]

CORRECTION

the product n factorial quantity first derivative with respect to x of

u raised to k1

AND SO ON

Quantity ennth derivative with respect to x of u raised to kn

DIVIDED BY

the product k1 factorial quantity one factorial raised to k1

AND SO ON

kn factorial quantity n factorial raised to kn

W tym miejscu widać

bezsiłę drukowanego tekstu. Dla oddania melodii zastosowanego przez

Ramana formatowania audialnego, w powyższym tekście zostały użyte

wyróżniki. Tak więc wykładniki k1 oraz kn zapisane w górnym indeksie

wymawiane są wysokim głosem. Jednak nie oddaje to wrażenia jakie ma

słuchacz. Osoby znające angielski zachęcamy do przesłuchania

znajdujących się na Sieci plików audio. Zostały one wykonane przez

digitalizację sygnału wytworzonego przez syntezator Dectalk, którym

posługiwał się Raman i są bardzo dobrej jakości. Warto jeszcze

dopowiedzieć, że Raman zaproponował dwie formy interpretacji takich

złożonych wyrażeń, różniące się między sobą poziomem przyswajania i

czasem odczytu. Raman umiejętnie posługuje się formatowaniem audialnym

zmieniając cechy głosu syntetycznego lektora w zależności od elementu

strukturalnego interpretowanego wzoru. Innym głosem syntezator

wypowiada podstawową linię formuły, innym licznik i mianownik ułamka,

jeszcze innym wykładniki. Spektakularne osiągnięcia Ramana w zakresie

formatowania audialnego tekstów technicznych obalają wszelkie

prymitywne stereotypy na temat możliwości zdobywania najwyższych

kwalifikacji przez osoby całkowicie niewidome i pokazują, jak wielkie

są możliwości tej grupy inwalidzkiej w zakresie prowadzenia

zaawansowanych prac (por. Czermiński [2001-2]).

Na marginesie omawianych tu spraw związanych z redakcją i odbiorem

tekstów przez osoby niewidome warto odnotować równie, a może nawet i

bardziej fascynujący fakt opracowania przez Heshama Kamela, niewidomego

doktoranta Uniwersytetu w Berkeley, pakietu pozwalającego niewidomym

tworzyć, przeglądać i edytować grafikę. Więcej informacji na ten temat

można znaleźć wizytując stronę internetową twórcy pakietu IC2D (

http://guir.berkeley.edu/projects/ic2d).

Czytelnik oswojony

z pracą edytorską w środowisku Windows ma w znakomitej większości

przypadków wbudowaną usługę wizualizacji tekstu w jego finalnym

formacie. W żargonie informatycznym znana jest ona pod nazwą standardu

WYSIWYG (ang. What You See Is What You Get - to co widzisz jest tym, co

otrzymujesz). Mało który edytor oferuje możliwość podejrzenia i

ewentualnie skorygowania znaczników, czy kodów formatujących tekst. Do

takich nielicznych pozytywnych przykładów możemy zaliczyć Word Perfect.

Pod klawiszem funkcyjnym F11 edytor ten oferuje funkcję edycji kodów

formatujących, określaną nazwą Reveal Codes (ujawnij kody). Ale zarazem

możemy powiedzieć z poczuciem pełnej odpowiedzialności, że funkcję taką

ma każdy tekst sformatowany zgodnie ze standardem SGML i jego

standardami następczymi (HTML, XML, STML, VRML). Każdy taki plik

edytowany pod edytorem znakowym (takim, jak np. MS NotePad) ujawnia

wszystkie atrybuty tekstu i znaczniki formatujące. Wynika z tego, że

cyfrowy tekstowy dokument elektroniczny ma dwie postaci, z których

jedna jest zawsze dostępna dla użytkownika, a druga może być dostępna

lub nie - w zależności od woli twórcy oprogramowania. Dla pierwszej

postaci zaproponujemy nazwę postać

prezentacyjna tekstu, dla drugiej przyjmiemy termin będący już w

użytkowaniu: postać źródłowa tekstu.

W normalnym trybie edytora lub przeglądarki dostępna jest postać

prezentacyjna. Postać prezentacyjna z kolei może się dzielić na

podpostacie zorientowane sprzętowo w zależności od rodzaju odbiorcy.

Można tu wymienić dominującą postać

wizualną, coraz bardziej popularną postać audialną, wreszcie rzadko

występującą postać sensoryczną.

Postać źródłowa publikacji internetowych dostępna jest w menu

przeglądarek pod pozycją "Widok" poprzez funkcję "Źródło".

Przyjrzyjmy się, jak udostępniane są obydwie postacie tego samego

tekstu przez różne pakiety oprogramowania. Tekst oryginalny został

przygotowany pod edytorem Word 97 i dodatkowo skonwertowany do formatów

HTML i WP ((WordPerfect). Konwersja ta spowodowała automatyczną zmianę

rodzaju czcionki z niedostępnego na platformie Word Perfecta Ariala na

najbardziej do niego zbliżoną czcionkę bezszeryfową jaką jest Univers

Condensed. MS Word 97 oferuje bardzo ograniczoną usługę dostępu do

źródłowej postaci tekstu. Tabela 11 ilustruje kształt postaci

prezentacyjnej i źródłowej tekstu widzianej przez pryzmat różnych

narzędzi programistycznych. Użytkownik tego edytora może kontrolować

wyświetlanie na ekranie kodów wewnętrznych edytora poprzez pozycję menu

Narzędzia, funkcję Opcje i zakładkę Widok. Wyjątkowo zwodnicza jest

możliwość pokazywania kodów wszystkich znaków niedrukowanych - to

dopiero pokazuje faktyczną skromność oferty Microsoftu.

Tabela 11. Postać prezentacyjna i postać źródłowa tekstu.

| Postać

tekstu |

Widok

na ekranie |

| Prezentacyjna (WYSIWYG) (MS Word 97, Word Perfect 6.0, Netscape Navigator, Internet Explorer) |

Electronic Document Morphology It should be noted that in a straightforward example it is possible to present semantically and graphically the same information using a number of different software |

| Źródłowa (Word Perfect 6.0) |

[Char Style On: heading 1][Just][Mrk

Txt ToC Begin][Font Size:14pt][Font:Univers Condensed][Lang] Electronic

Document Morphology][Mrk Txt ToC End][Bold Off][HRt] [Char Style Off:

heading 1] It should be noted that in a straightforward example

it is possible to present semantically and graphically the same

information using a number of different software |

| Źródłowa (Netscape Navigator, Internet Explorer) |

<B><FONT

FACE="Arial" SIZE=4><P>Electronic Document Morphology</P></B></FONT><FONT

SIZE=2> <P ALIGN="JUSTIFY"> It should be noted that in a straightforward example it is possible to present semantically and graphically the same information using a number of different software </P></FONT> |

Mając do dyspozycji tekst w postaci

źródłowej, użytkownik dysponuje w pełni przewidywalnymi zachowaniami

systemu. To właśnie ten element przyczynił się do tak wielkiego sukcesu

systemu TEX w środowiskach technicznych. Czy się jednak to komu podoba

czy nie, dominująca liczba tzw. przeciętnych użytkowników preferuje

systemy WYSIWYG i należy przypuszczać, że proporcja ta nie ulegnie

zmianie. Piszący te słowa z konieczności umotywowanej brakiem czasu sam

używa pakietu MS Office 2000, choć dysponuje przykładowym plikiem w

formacie WORDa, nie spełniającym postulatu WYSIWIG: w tekstowym

dokumencie zaszyty jest obrazek, którego nie widać na ekranie, ale

który jest drukowany na drukarce. Nie ma wątpliwości, że obecnie

stosowane oprogramowanie w większości wypadków jest dalekie od

doskonałości. Na zakończenie warto wspomnieć, że przez wiele lat

prawdziwą furorę budził zaprojektowany przez S. Jobsa system operacyjny

NeXT Step (i jego potomek OPEN STEP). Cechowała go jednolita

technologia obsługi zarówno drukarki, jak i ekranu: był to PostScript.

To powodowało przewidywalne zachowanie się systemu u końcowego

użytkownika. NeXT Step dobrze odpierał atak krytyki na

nieprzewidywalność efektów artystycznych na stacji roboczej końcowego

użytkownika, ale - mówiąc szczerze – był to użytkownik elitarny. Fakt

ten okupiony był jednak znacznymi ograniczeniami: dla platformy

intelowskiej producent systemu publikował listę produktów mających

atest zgodności sprzętowej. Dotyczyło to płyt głównych, kart

graficznych, kart dźwiękowych, kontrolerów SCSI itp. Niestety koszty

rozwoju takiego systemu są bardzo wysokie, i firma nie była w stanie

nadążyć z pisaniem sterowników obsługujących ogrom pojawiających się

nowych produktów rynkowych. NeXT Step urodził się za wcześnie, gdy

stopień standaryzacji sprzętowej jeszcze był niski, a moc przetwarzania

pod każdym względem zbyt mała. Jak to wspomniano uprzednio, wraz z

wprowadzeniem systemu operacyjnego Windows 2000 Microsoft ośmielił się

opublikować na swej stronie domowej wykaz sprzętu posiadającego atest

zgodności z tym systemem. Fakt ten staje się nowym wyzwaniem dla

użytkowników oprogramowania produkowanego przez tą firmę rokującym

zbliżone kłopoty do tych, które mieli użytkownicy NeXT Stepa

instalowanego na platformie intelowskiej.

Jak wyżej pokazano na przykładach, edytor

może należeć do jednej z trzech grup:

- Oferującej wyłącznie formę prezentacyjną (np. MS Word)

- Oferującej zarówno formę prezentacyjną, jak i źródłową (Corel Word Perfect 8. niektóre edytory HTML)

- Oferującej wyłącznie formę źródłową (takim jest np. S.C. UniPad

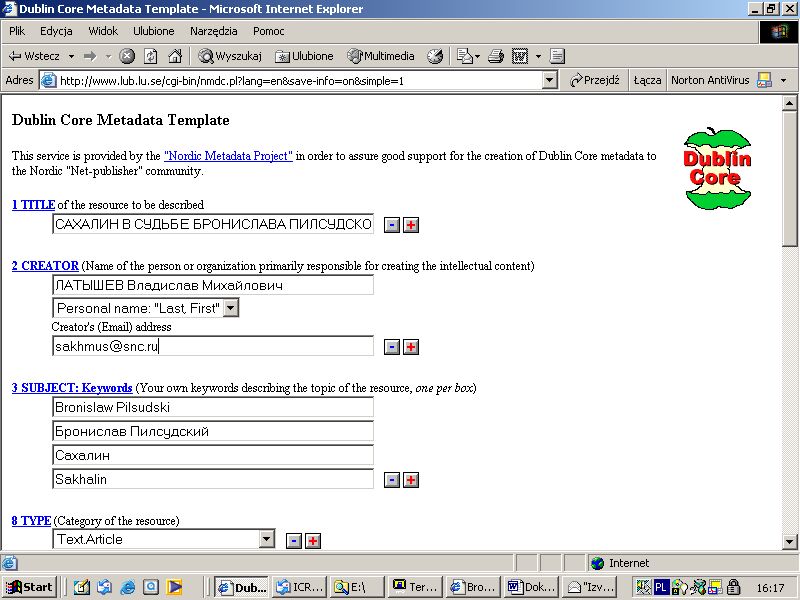

Można by się spodziewać, że w przypadku Worda użytkownik ma do dyspozycji klasyczną usługę WYSIWYG: na drukarce dostajesz to co widzisz. Jak do tej chwili nie jest to prawdziwe. Microsoftowski Word nadal jest niespójny wewnętrznie. Jak długo w menu Worda w pozycji Widok będzie się znajdowało okienko z trzema opcjami przeglądania dokumentu: ‘Normalny’, ‘Układ sieci Web’ oraz ‘Układ strony’, - tak długo użytkownik musi zdawać sobie sprawę, że w danym momencie ogląda tylko jeden z możliwych obrazów tworzonego dokumentu. Te obrazy mogą się od siebie bardzo różnić. Tak np. w układzie normalnym Word nie pokazuje pól tekstowych. Celem zilustrowania takiego przypadku przygotowany został plik w formacie Word zawierający pola tekstowe. Poniższe rysunki są zrzutami ekranu tworzonymi w trakcie przeglądania tego pliku w układzie normalnym (Rysunek 22) oraz w układzie strony (Rysunek 23).

Rysunek 22. Tekst

dokumentu alyakhtund.doc w układzie normalnym. Opracowanie autora.

|

Rysunek 23. Tekst dokumentu alyakhtund.doc w układzie strony. Opracowanie autora

|

Песни,

посвящённые <не. Poland, 18 April 2002 Бронислав Пилсудский Вунит,

сестра Чурки, поэтесса, зная что я очень люблю песни, решила составить

песню, обращённую ко <не. Когда я ездил (в 1897 г.) по гилякски<

селения<, обучая гиляков солить рыбу, она жила в с. Кезириво, лежаще<

на островке по р. Ты<и близ Мозьб’ во . Аляхтунд. Акан–

тох алеhынд.*  Кезириво фина /

|

Jak widać z

powyższych przykładów, obydwa obrazy znacznie różnią się między sobą.

Układ strony jest prawdopodobnie najbliższy usługi WYSIWIG i z dużym

prawdopodobieństwem można orzec, że tak właśnie będzie wyglądał wydruk

na drukarce kolorowej, natomiast z całą pewnością nie będzie tak

wyglądał wydruk na drukarce biało-czarnej. Natomiast układ normalny

jest jakąś formą uproszczoną, która może nie zawierać pewnych

elementów. Powyższe komentarze pozwalają zrozumieć, dlaczego na

Zachodzie przereklamowanym standardom przemysłowym szybko dokleja się

uszczypliwe etykietki, Tak więc w szczególności usługa WYSIWIG bywa

przezywana WYSIWYNG (ang. What You See Is What You Never Get – to co

widzisz jest tym, czego nigdy nie otrzymasz).

Przytoczona analiza porównawcza ujawnia polimorfizm cyfrowego dokumentu

elektronicznego, widziany przez pryzmat standardowych narzędzi

środowiska edycyjnego i prezentacyjnego (monitor, drukarka

biało-czarna, drukarka kolorowa). Polimorfizm ten jest wyrazem

kompromisu jaki producent oprogramowania chce osiągnąć; jest wyrazem

balansu pomiędzy spodziewanymi potrzebami użytkownika i ofertą

konkurencji. Związane z nim niejednoznaczności mogą poważnie spowalniać

procesy redakcyjne i w ostateczności nawet wprowadzać deformacje do

postaci prezentacyjnej.

Elektroniczny dokument cyfrowy musi być postrzegany jako byt

zintegrowany ze światem, w którym go wytworzono, i do którego winien

należeć. Przenoszenie go do niekompletnego środowiska mającego inne

wersję oprogramowania użytkowego, sterowniki, fonty czy obsługę ekranu

może poważnie zmienić jego cechy. W końcu nawet meduza wyrzucona przez

fale na morski brzeg jest tylko marną karykaturą misternego organizmu

zawieszonego w wodzie.

Stwierdzenie, że

wielojęzyczność jest immanentnie związana z komunikacją międzynarodową

- pieszą, morską czy lotniczą - jest chyba dla wszystkich oczywiste.

Dokumentom wielojęzycznym już w starożytności przypisywano ponadczasową

wartość. Najlepszym przykładem takiego dokumentu jest pieczołowicie

przechowywana w British Museum bazaltowa stela znana pod nazwą Kamienia

z Rosetty. To dzięki uwiecznionemu na tym kamieniu trójjęzycznemu

zapisowi (hieroglify egipskie, pismo demotyczne i pismo greckie) Jean

François Champoillon był w stanie odcyfrować niezrozumiałe już od dwóch

tysiącleci egipskie hieroglify. Nie od rzeczy będzie też przypomnieć,

że jeden z naszych najciekawszych zabytków – „Psałterz floriański” –

zawiera 150 psalmów pisanych w trzech językach: łacińskim, polskim i

niemieckim. Jednak wielojęzyczne dokumenty najczęściej nie występują w

zbiorach specjalnych, lecz w podręcznym księgozbiorze każdej czytelni:

są to słowniki, tak pożyteczne przy bieżącej pracy.

W dzisiejszych czasach ożywiona wymiana handlowa nasyca światowe rynki

towarem z wielojęzycznym opisem. Mamy go na słoikach z dżemem, w

instrukcjach obsługi pralek i telewizorów, w opisach informacyjnych

filmów fotograficznych i leków, na okładkach międzynarodowych biletów

lotniczych i kolejowych. Bodaj czy nie jeszcze bujniej rozwija się

produkcja materiałów wydawniczych w muzeach. Świat stał się nie tylko

bardziej wielojęzyczny, ale i wielokulturowy. Ciekawy przegląd

współczesnych zagadnień związanych z wielojęzycznością zaprezentowała

niedawno Borgman [1997]. Autorka spostrzega fakt pojawienia się na

świecie wielkiej ilości materiału cyfrowego i koncentruje się na

konieczności unifikacji zasad kodowania w ramach Unicode'u.

W ostatnich latach poligrafia światowa całkowicie zmieniła swoje

oblicze. Obecnie większość tekstów wielojęzycznych sporządza się

komputerowo. Czy wszystko jednak da się tu zrobić? Jakie są

ograniczenia w poligrafii, a jakie w edytorstwie internetowym? Jakie są

współczesne tendencje w zakresie katalogowania wydawnictw

obcojęzycznych?

W następnych paragrafach dyskusję wybranych tu problemów ilustrować

będziemy przykładami z dalekowschodniego obszaru językowego. Podobne

ilustracje tekstowe przez długie lata były przyjmowane z dreszczykiem

emocji, teraz stają się powoli codziennością.

W syntetycznym

skrócie techniczne problemy związane z obsługą tekstów wielojęzycznych

można pogrupować na następujące kategorie:

- wprowadzanie znaków tekstu

- aspekt sprzętowy (klawiatura, sieć poprzez adapter sieciowy, terminal włączony poprzez interfejs szeregowy, mikrofon włączony do karty dźwiękowej plus oprogramowanie rozpoznawania mowy)

- aspekt programowy (graficzne kompozery złożonych znaków z predefiniowanych struktur, tezaurusy, przełączniki kierunkowości zapisu: lewa do prawej, prawa do lewej, pisanie poziomo, pisanie pionowo)

- prezentacja znaków tekstu poprzez urządzenie peryferyjne komputera (ekran, drukarka)

- formatowanie tekstu identyfikujące język mówiony na potrzeby obsługi syntezy mowy (programowa synteza przez kartę dźwiękową lub sprzętowa przez autonomiczny syntezator mowy traktowany jako urządzenie peryferyjne)

- kodowanie znaków (wybór standardów,transkodowanie online, migracje)

- definiowanie sekwencji sortujących terminy i sekwencji określających tryb przeszukiwania i interpretacji tekstu wielojęzycznego

- automatyczne tworzenie streszczeń i indeksu słów kluczowych

- automatyczne tłumaczenia online

Warto teraz przyjrzeć się kilku wybranym technikom wprowadzania dalekowschodnich tekstów do dokumentu. Rozwój i powszechna akceptacja standardu okienkowego (Apple, Microsoft, X-Windows) stworzyły nową możliwość oferowania przez aplikację dodatkowych usług, niezwykle upraszczających proces edycyjny. Najprostszym (i zarazem najbardziej powolnym) sposobem wprowadzenia tekstu jest pobieranie pojedynczych znaków z posiadanego repertuaru. Nie zamykając edytora użytkownik może wywołać sobie małą przeglądarkę dostępnych znaków, posługując się funkcją Wstaw z poziomu głównego menu edytora, i wybierając z listy pozycję Symbol. Po ukazaniu się okienka dialogowego funkcji Symbol należy wybrać font, zawierający potrzebny podzbiór znaków (w cytowanym przykładzie jest to Hiragana). Jeśli wybrany zostanie font unikodowy, to po prawej stronie okna dialogowego udostępnione zostaje dodatkowe okno podzbioru grupy językowej (np. cyrylica, czy ujednolicone ideogramy CJK). Potrzebny znak wskazuje się myszką, a następnie przenosi się go do głównego okna edytora poprzez aktywizację pozycji Wstaw. Przy rutynowym wpisywaniu obcojęzycznego tekstu użytkownik może oczywiście ostrożnie zredefiniować sobie klawiaturę [47] przy pomocy pozycji Klawisz skrótu. Rysunek 24 przedstawia przykładowe wpisywanie tekstu japońskiego indywidualnie wybieranymi znakami z podzbioru Hiragana:

Rysunek 24.

Wprowadzanie tekstu japońskiego w edytorze Word 97 (wybieranie znaków

sylabami z puli systemowej fontu Arial Unicode MS). Opracowanie autora.

| Proszę

pisać - Microsoft Word |

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

| Plik | Edycja |

Widok |

Wstaw |

Format |

Narzędzia |

Tabela |

Okno |

Pomoc |

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

かいてくだ

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Przyjrzyjmy się z

kolei, na ile szersze techniczne możliwości tworzenia napisów w

językach dalekowschodnich daje edytor wprowadzania IME (ang. Input

Method Editor) firmy Microsoft (Rysunek 25).

Rysunek 25. Edytor

IME. Opracowanie autora.

| Dokument10 - Microsoft Word | |||||||||||||||||

| Plik | Edycja | Widok | Wstaw | Format | Narzędzia | Tabela | Okno | Pomoc | |||||||||

|

Karafuto からふと

|

|||||||||||||||||

W klasyfikacji

Tuckera [1987] IME podpada pod kategorię systemów konwersji fonetycznej

(ang. phonetic conversion systems). Narzędzie to jest swojego rodzaju

kombajnem, operującym w środowisku edytorów obsługujących format HTML,

umożliwiającym posłużenie się transkrypcją z poziomu klawiatury

angielskiej i opcjonalnym, bardzo dogodnym tezaurusem, usłużnie

podstawiającym alternatywne skrypty z listy dostępnych sylabariuszy

(japoński). Dodatkowo IME oferuje czcionkę standardową, lub połowicznej

szerokości (tą ostatnią tylko dla katakany i znaków ASCII). W IME tekst

japoński wprowadzamy do otwartego już dokumentu w transkrypcji

Hepburna. Edytor podsuwa jednak piszącemu trzy możliwości prezentacji

tekstu na ekranie: albo tekst niekonwertowany (romaji) albo

automatycznie konwertowany do hiragany lub katakany. Jeśli po

zakończeniu pisania jakiegoś słowa naciśniemy klawisz spacji, to

wyświetlone zostanie okienko z listą proponowanych alternatywnych form

zapisu (homofony). Rysunek 21 ilustracją, obrazującą sposób wyboru

zapisu nazwy Karafuto - japońskiego określenia wyspy Sachalin, gdzie

więziony był Bronisław Piłsudski. Na rysunku widać od góry alternatywne

formy prezentacji: katakanę, kanji, hiraganę (wszystkie trzy w pełnej

szerokości), katakanę w połowicznej szerokości czcionki i pięć wersji

romaji w obydwu szerokościach czcionki (pozycje 5-9).

W miarę poprawy parametrów technicznych ekranu (ogniskowanie, aberracje

odchylania, zdolność rozdzielcza) adaptera graficznego oraz mocy

przetwarzania procesora zaczęły narastać apetyty na bardziej

wyrafinowane metody tworzenia tekstów wielonarodowych. Przyjrzyjmy się

na koniec (Rysunek 26) interesującemu narzędziu, oferowanemu przez

firmę Aurora w ramach pakietu dla bibliotek i służącemu do wprowadzania

znaków alfabetu chińskiego

[48]. Przedstawiane narzędzieto czteropoziomowy kompozer złożonych znaków chińskich w oparciu o pule

prymitywów składniowych. Ideę jego przedstawiamy w postaci tablicy

podzielonej na cztery sekcje z których pierwsza ogranicza się tylko do

jednej kolumny zawierającej znaki oparte na różnych dwuwymiarowych

orientacjach pojedynczej kreski (prosta pozioma, prosta pionowa, i dwie

wygięte). Dwie następne sekcje (druga i trzecia), o szerokości 5

komórek każda, zawierają ideogramy średniego stopnia złożoności służące

do kompozycji finalnego znaku znajdującego się w sekcji czwartej. W

rzeczywistym edytorze Jianyi Bushou sekcje przedzielone są suwakami

pozwalający wybrać z obszernego pola potrzebny do kompozycji prymityw.

Wynika z tego, że złożoność znaku narasta od lewej strony do prawej. W

klasyfikacji Tuckera [1987] narzędzie to należy do systemów

kompozycyjnych (ang. composition systems) i może się okazać bardzo

przydatne przy zapisie chińskich imion własnych, spotykanych na tyle

rzadko, że żadna instytucja nie będzie zainteresowana poszukiwaniem

takiego samego znaku w innym obszarze językowym tak, jak to miało

miejsce przy unifikacji ideogramów CJK.

Rysunek 26. Edytor kompozycyjny. Opracowanie własne na podstawie

materiałów firmy Aurora.

|

|||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||||

Bardzo poważnym

problemem jest kodowanie znaków narodowych. Jeśli nie odwoływać się do

historii budowy Wieży Babel, to przypisanie kodów do konkretnych znaków

tradycyjnego pisma zawsze miało posmak narodowy i doskonale

odzwierciedlało wolę narodów i grup językowych do samostanowienia. Prym

wiedli tu Amerykanie, mający najwięcej sprzętu komputerowego i przez

wiele lat ignorujący wartość poznawczą poza-anglojęzycznych tekstów.

Proponowane przez nich repertuary znaków takie jak EBCDIC, czy też

ASCII w założeniach swoich odsuwały w niebyt istnienie innych

repertuarów znaków, orientując się głównie na sfery biznesowe. Europa,

przyglądająca się tym wyczynom z oddali, i dalekowschodnia Azja, może z

nieco mniejszym dystansem z powodu swego dalszego zaawansowania

technologicznego, zaczęły na własną rękę tworzyć standardy narodowe i

międzynarodowe, oraz inicjować regionalne prace unifikacyjne (por.

Tseng i in. 1987). Regionalność zaczęła być oznaczana anagramami: LGC

(Latin + Greek + Cyrillic), CJK (Chinese + Japanese + Korean), JACKPHY

(Japanese, Chinese, Korean, Persian [Farsi], Hebrew, Yiddish). To

sobiepaństwo w zakresie standardów kodowania stało się wyjątkowo

uciążliwym hamulcem w rozwoju globalnej wioski. Te różne standardy na

ogół bez przeszkód mogą współistnieć pokojowo obok siebie w jednej

bazie danych. Niemal w każdym rekordzie bazy danych może zostać wpisana

sekwencja znaków zgodna z innym standardem. Jest nawet osobna norma

(ISO 2022) regulująca mechanizmy przełączania się między różnymi

systemami kodowania. Jednak z faktu istnienia jakiegoś zapisu nie

wynika jeszcze możliwość odczytania. Czytelnik może się przekonać o tym

osobiście, wizytując np. serwer testowy Z39.50 Research Library Group i

filtrując rekordy zawierające pole 066. Bez posiadania

specjalistycznego oprogramowania (np. sprzedawanego przez RLG) nie ma

szans na poprawne obejrzenie zapisów w języku oryginału (zazwyczaj są

one w polu 880). Jest jeszcze jedno ważne ograniczenie - tym razem

dotyczące plików pełnotekstowych. W jednym pliku HTML nie można używać

kilku różnych standardów kodowania! Zamiar wydawania wielojęzycznej

publikacji w Internecie niemal skazuje wydawcę na stosowanie standardu

Unicode.

Przyjrzymy się, jak na tą samą przestrzeń adresową (kody z przedziału

128 - 254) poszczególne grupy narodowościowe nakładały swoje znaki w

ramach normy ISO 8859-x:

Tabela 12. Współdzielenie przestrzeni kodów przez różne normy ISO

8859-x

ISO 8859-1

|

A0

|

A1 ¡ |

A2 ¢ |

A3 £ |

A4 ¤ |

A5 ¥ |

A6 ¦ |

A7 § |

A8 ¨ |

A9 © |

AA ª |

AB « |

AC ¬ |

AD |

AE ® |

AF ¯ |

|

B0 ° |

B1 ± |

B2 ² |

B3 ³ |

B4 ´ |

B5 µ |

B6 ¶ |

B7 · |

B8 ¸ |

B9 ¹ |

BA º |

BB » |

BC ¼ |

BD ½ |

BE ¾ |

BF ¿ |

|

C0 À |

C1 Á |

C2 Â |

C3 Ã |

C4 Ä |

C5 Å |

C6 Æ |

C7 Ç |

C8 È |

C9 É |

CA Ê |

CB Ë |

CC Ì |

CD Í |

CE Î |

CF Ï |

|

D0 Ð |

D1 Ñ |

D2 Ò |

D3 Ó |

D4 Ô |

D5 Õ |

D6 Ö |

D7 × |

D8 Ø |

D9 Ù |

DA Ú |

DB Û |

DC Ü |

DD Ý |

DE Þ |

DF ß |

|

E0 à |

E1 á |

E2 â |

E3 ã |

E4 ä |

E5 å |

E6 æ |

E7 ç |

E8 è |

E9 é |

EA ê |

EB ë |

EC ì |

ED í |

EE î |

EF ï |

|

F0 ð |

F1 ñ |

F2 ò |

F3 ó |

F4 ô |

F5 õ |

F6 ö |

F7 ÷ |

F8 ø |

F9 ù |

FA ú |

FB û |

FC ü |

FD ý |

FE þ |

FF ÿ |

ISO 8859-2

|

A0

|

A1 Ą |

A2 ˘ |

A3 Ł |

A4 ¤ |

A5 Ľ |

A6 Ś |

A7 § |

A8 ¨ |

A9 Š |

AA Ş |

AB Ť |

AC Ź |

AD ¯ |

AE Ž |

AF Ż |

|

B0 ° |

B1 ą |

B2 ˎ |

B3 ł |

B4 ´ |

B5 Ĭ |

B6 Ś |

B7 ˅ |

B8 ¸ |

B9 š |

BA ş |

BB ť |

BC ź |

BD ˝ |

BE ž |

BF ż |

|

C0 Ŕ |

C1 Á |

C2 Â |

C3 Ă |

C4 Ä |

C5 Ĺ |

C6 Ć |

C7 Ç |

C8 Č |

C9 É |

CA Ę |

CB Ë |

CC Ĕ |

CD Í |

CE Î |

CF Ď |

|

D0 Ð |

D1 Ń |

D2 Ň |

D3 Ó |

D4 Ô |

D5 Ő |

D6 Ö |

D7 × |

D8 Ř |

D9 Ů |

DA Ú |

DB Ű |

DC Ü |

DD Ý |

DE Ţ |

DF ß |

|

E0 ŕ |

E1 á |

E2 â |

E3 ă |

E4 ä |

E5 ĺ |

E6 ć |

E7 ç |

E8

|

E9 é |

EA ę |

EB ë |

EC ě |

ED í |

EE î |

EF ɗ |

|

F0 đ |

F1 ń |

F2 ň |

F3 ó |

F4 ô |

F5 ő |

F6 ö |

F7 ÷ |

F8 ř |

F9 ů |

FA ú |

FB ű |

FC ü |

FD ý |

FE ƫ |

FF ' |

ISO 8859-5

|

A0 |

A1 Ё |

A2 Ђ |

A3 Ѓ |

A4 Є |

A5 Ѕ |

A6 І |

A7 Ї |

A8 Ј |

A9 Љ |

AA

|

AB Ћ |

AC Ќ |

AD |

AE Ў |

AF Џ |

|

B0 А |

B1 Б |

B2 В |

B3 Г |

B4 Д |

B5 Е |

B6 Ж |

B7 З |

B8 И |

B9 Й |

BA К |

BB Л |

BC М |

BD Н |

BE О |

BF П |

|

C0 Р |

C1 С |

C2 Т |

C3 У |

C4 Ф |

C5 Х |

C6 Ц |

C7 Ч |

C8 Ш |

C9 Щ |

CA Ъ |

CB Ы |

CC Ь |

CD Э |

CE Ю |

CF Я |

|

D0 а |

D1 б |

D2 в |

D3 г |

D4 д |

D5 е |

D6 ж |

D7 з |

D8 и |

D9 й |

DA к |

DB л |

DC < |

DD н |

DE о |

DF п |

|

E0 р |

E1 с |

E2 т |

E3 у |

E4 ф |

E5 х |

E6 ц |

E7 ч |

E8 ш |

E9 щ |

EA ъ |

EB ы |

EC ь |

ED э |

EE ю |

EF я |

|

F0 а |

F1 ё |

F2 ђ |

F3 ѓ |

F4 є |

F5 ѕ |

F6 і |

F7 ї |

F8 ј |

F9 љ |

FA њ |

FB ћ |

FC ќ |

FD § |

FE ў |

FF џ |

|

A0 |

A1 ʽ |

A2 ʼ |

A3 £ |

A4

|

A5

|

A6 ¦ |

A7 § |

A8 ¨ |

A9 © |

AA

|

AB « |

AC ¬ |

AD - |

AE |

AF ¯ |

|

B0 ° |

B1 ± |

B2 ² |

B3 ³ |

B4 ´ |

B5 ΅ |

B6 Ά |

B7 · |

B8 Έ |

B9 Ή |

BA Ί |

BB » |

BC Ό |

BD ½ |

BE Ύ |

BF Ώ |

|

C0 ΐ |

C1 Α |

C2 Β |

C3 Γ |

C4 Δ |

C5 Ε |

C6 Ζ |

C7 Η |

C8 Θ |

C9 Ι |

CA Κ |

CB Λ |

CC Μ |

CD Ν |

CE Ξ |

CF Ο |

|

D0 Π |

D1 Ρ |

D2 |

D3 Σ |

D4 Τ |

D5 Υ |

D6 Φ |

D7 Χ |

D8 Ψ |

D9 Ω |

DA Ϊ |

DB Ϋ |

DC ά |

DD έ |

DE ή |

DF ί |

|

E0 ΰ |

E1 α |

E2 β |

E3 γ |

E4 δ |

E5 ε |

E6 ζ |

E7 η |

E8 θ |

E9 ι |

EA κ |

EB λ |

EC μ |

ED ν |

EE ξ |

EF ο |

|

F0 π |

F1 ρ |

F2 ς |

F3 σ |

F4 τ |

F5 υ |

F6 φ |

F7 χ |

F8 ψ |

F9 ω |

FA ϊ |

FB ϋ |

FC ό |

FD ύ |

FE ώ |

FF

|

Mechanizmy

przełączania sekwencji escape są bardzo kłopotliwe w praktycznej

implementacji. Przeciętny śmiertelnik nie może na swoim komputerze

osobistym obejrzeć takich zasobów cyfrowych. Trudno się dziwić, że przy

pierwszej nadarzającej się okazji rozpoczął się odwrót od tej

technologii na rzecz jednolitej metody kodowania. Zmiana postawy

amerykańskiej nastąpiła, jak się wydaje, w mniejszym stopniu na skutek

nacisku światłych sfer akademickich, a bardziej w wyniku spodziewanych

beneficji z tytułu obrotu handlowego z ogromnymi i chłonnymi rynkami

azjatyckimi. Czynnikiem zwiastującym początek nowej ery w stosunkach

gospodarczych było zniknięcie "żelaznej kurtyny". Synchronicznie z

latami tego przełomu na początku lat 90-tych rodzą się dwie niezależne

inicjatywy ujednolicenia zasad kodowania: pierwszej przewodzi grupa

amerykańskich producentów sprzętu i oprogramowania komputerowego,

drugiej - International Organization for Standardization (ISO).

Pierwsza grupa zawiązała korporację w styczniu 1991 r. pod nazwą

Unicode Inc. W tym samym roku obie zainteresowane strony doszły do

porozumienia, że dysponowanie jednym, spójnym kodem, obejmującym

wszystkie znaki obecnie znane, jest sprawą godną najwyższego poparcia.

Wzajemnie zaakceptowane zmiany zostały wprowadzone do Wersji 1.0

standardu Unicode, oraz do wstępnego dokumentu ISO/IEC Draft

International Standard DIS 10646.1. Połączenie obydwu nastąpiło w

styczniu 1992 roku. Końcowa postać tej wersji standardu została

opublikowana w 1993 r. Już w zaraniu egzystencji tego nowego standardu

stało się jasne, że kończy się czas funkcjonowania mechanizmów

przełączania między różnymi repertuarami znaków, i że należy się jak

najszybciej wycofać z używania ISO 2022, oraz standardów o zasięgu

lokalnym i regionalnym, takich jak rodzina ISO 8859-x na rzecz

Unicode'u [Aliprand 1992].

Konwencje notacyjne Unicode'u

Poniższy wybór

został opracowany na podstawie 2 wersji standardu. Wszystkie znaki

Unicode mają jednoznaczne nazwy składające się wyłącznie z dużych

łacińskich

[49] liter od A do Z, odstępui myślnika - minusu. Nazwy alternatywne (aliasy) pisane są kursywą.

W tekście niniejszym pojedyncza wartość unikodu

[50]zapisywana jest jako U+nnnn,

gdzie nnnn jest

czterocyfrową liczbą w zapisie heksadecymalnym. Na przykład U+0041 jest

wartością unikodu znaku nazywanego LATIN CAPITAL LETTER A.

Ideogramy wschodnio-azjatyckie nazywane

[51] sąCJK UNIFIED IDEOGRAPH-X, gdzie X zastępowany jest heksadecymalną

wartością unikodu

Projekt Unicode'u

został oparty na następujących 10 zasadach wypunktowanych w definicji

standardu:

- Kody znaków standardu mają jednolitą szerokość 16 bitów

- Cała 16-bitowa przestrzeń kodowa jest dostępna dla kodowania znaków

- Standard określa kodowanie znaków, a nie kształtów. Na przykład A A A A A A , to różne kształty tego samego znaku U+0041 LATIN CAPITAL LETTER A.

- Znaki mają dobrze zdefiniowane znaczenie

- Standard Unicode służy do kodowania tekstu

- Domyślne rozlokowanie znaków tekstu w pamięci jest w porządku logicznym (to jest w takim porządku, w jakim tekst jest pisany na klawiaturze). Gdy tekst komponowany z angielskiego i arabskiego (lub hebrajskiego) ma być przesłany na ekran, wtedy logiczny porządek słów pamiętanych w pamięci zmienia się, aby umożliwić poprawną prezentację tekstu, składającego się z zapisów czytanych z lewej do prawej oraz czytanych z prawej do lewej.

- Gdziekolwiek jest to możliwe, standard Unicode scala znaki duplikujące się w różnojęzycznych zapisach. Francuskie igrecque, niemieckie ypsilon, angielskie wye, wszystkie są reprezentowane przez kod tego samego znaku U+0059 LATIN CAPITAL LETTER Y. Podobnie chińskie zi, japońskie ji oraz koreańskie ja, wszystkie są reprezentowane przez kod tego samego znaku, U+5B57 CJK UNIFIED IDEOGRAPH 字 . Autor niniejszej książki pozwala sobie mieć krytyczny stosunek co do pełnego sukcesu standaryzacji zaleconej w tym punkcie. Litera Y została zaimportowana do łaciny z greckiego a dalej do języków nowożytnych, o czym najlepiej świadczy wymowa takiej pojedynczej litery we francuskim, polskim i niemieckim. Jednak ten sam znak jest odmiennie kodowany w obu tych grupach językowych: U+0059 Y LATIN CAPITAL LETTER Y oraz U+03A5 Y GREEK CAPITAL LETTER UPSILON. To samo dotyczy wielu innych znaków (jak np. A w cyrylicy). Z pewnością trudność w standaryzacji bierze się z faktu, że kryterium rozróżnienia znaków nie jest oparte ani na fonetyce ani na kształcie znaku, tylko dość abstrakcyjnie i dowolnie zdefiniowanej semantyce znaku. Ale z drugiej strony bardzo sensownie zgrupowano w osobnym bloku kodu rzymskie liczby i tak np. znak M interpretowany jako łacińska litera ma kod 0041, natomiast interpretowany jako cyfra rzymska "jeden tysiąc" ma kod 216F. W tym samym bloku numerycznym jest osobno wyróżniona alternatywna reprezentacja tego znaku o której wspomniano wcześniej omawiając inskrypcję na grobie Machiavellego. Zapisana tam sekwencja 10 znaków: CIƆIƆXXVII ma swój poprawny unkodowy odpowiednik w postaci 5 znaków ↀⅮⅩⅩⅦ zdecydowanie określających dedykowaną semantykę numeryczną. Uwagi godne jest przy tym to, że "jeden tysiąc" traktowany jest w arytmetyce rzymskiej jako cyfra; podobnie cyfra rzymska Ⅶ jest jednym znakiem, a nie konkatenacją trzech znaków.

- Standard Unicode dopuszcza dynamiczną kompozycję form akcentowanych.

- Dla prekomponowanych form statycznych standard Unicode zapewnia odwzorowanie na równoważne sekwencje dynamicznie komponowanych znaków.

- Zagwarantowano

dokładne przekształcanie Unicode na inne powszechnie stosowane

standardy i vice versa.

Font unikodowy

Z faktu, że grupa ekspertów była w stanie

doprowadzić do publikacji dokumentu, w którym każdemu wydrukowanemu

znakowi przypisuje się jednoznacznie kod, nie wynikało jeszcze, że

oprogramowanie znajdujących się w użytku komputerów posiada czcionkę

unicodową, ale - co ważniejsze - umie poprawnie obsłużyć nowy standard.

Bardzo szybko, bo już w 1993 roku Bigelow i Holmes opublikowali detale

swego projektu nacelowanego na konstrukcję fontu unikodowego.

Zaprojektowany i wykonany przez nich font o nazwie Lucida Sans Unicode

True Type Font obejmował 1700 znaków z rodziny języków wywodzących się

z łaciny plus greka (nowożytna), plus cyrylica, to znaczy pełne

środowisko LGC. Ponadto hebrajski, znaki fonetyczne, ramki oraz znaki